История артефактов Трансформеров и последние исследования по их устранению.

Делиться

Трансформеры заложили основу для базовых моделей, которые позволяют нам использовать предварительно обученные модели и применять их к различным задачам. Однако в моделях трансформеров встречается распространенный артефакт, который может оказывать негативное влияние на конкретные задачи и сценарии. Непонимание этих недостатков может привести к существенному снижению производительности вашего проекта или его провалу. Например, на странице DINOv2 в GitHub представлены модели, предварительно обученные с регистрами и без них. Таблица с метриками показывает, что регистры, введенные для устранения этого артефакта, не оказывают существенного влияния на модель. И зачем усложнять модель, если это не приводит к повышению точности?

Однако метрики, показанные на странице DINOv2, относятся только к классификации ImageNet, на которую, как известно, эти артефакты не влияют. Если вы используете модель VIT DINOv2 без регистров для обнаружения объектов (как в LOST), ваша производительность, вероятно, будет существенно хуже.

Использование предварительно обученных моделей ViT без понимания того, когда артефакты, соответствующие высоким нормам, могут повлиять на ваш проект, может привести к его провалу.

С момента выявления этих артефактов исследовательское сообщество разработало несколько методов для их устранения. Новейшие решения требуют минимальной или нулевой переподготовки и не вносят дополнительной задержки во время тестирования. Эти явления не уникальны для ViT, но также встречаются в LLM. Фактически, одна из статей NeurIPS 2025, рассмотренная здесь, предлагает общее решение этих артефактов «поглотителя внимания» — оно модифицирует архитектуру трансформера самовнимания. Показано, что эта модифицированная архитектура полезна во многих отношениях и уже внедряется в последнюю модель Qwen, Qwen3-Next.

Данная статья представляет собой исчерпывающее руководство по следующим вопросам:

- Регистры трансформатора.

- Артефакты, относящиеся к высоким нормативным показателям (или «ловушки внимания»), которые они рассматривают.

- Новейшие научно обоснованные решения для уменьшения этих артефактов.

1. Обнаружение артефактов в витаминах с помощью DINOv2

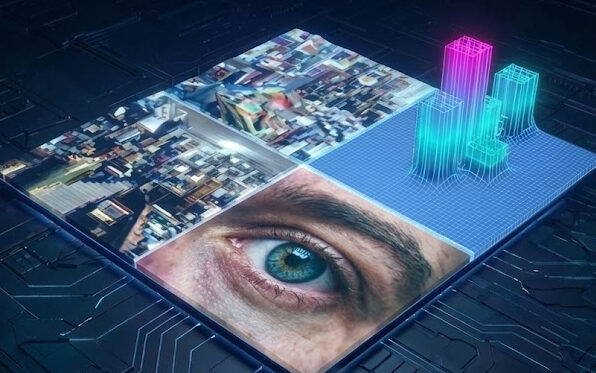

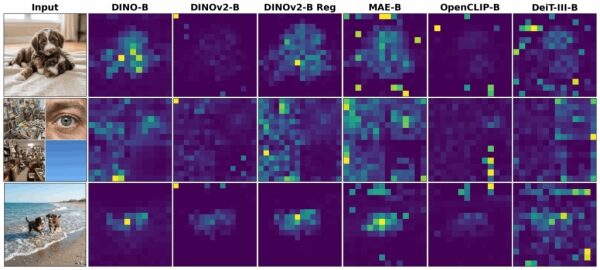

Хотя модели ViT сыграли ключевую роль в становлении эры базовых моделей для компьютерного зрения, они страдают от устойчивой аномалии: появления высоких нормальных пиков¹. Эти артефакты наблюдаются как при обучении с учителем, так и при самообучении, за исключением оригинальной модели DINO. На рисунке 1 это продемонстрировано на базовых моделях ViT, обученных с использованием различных алгоритмов, охватывающих самообучение (DINO/DINOv2, MAE), слабо контролируемое обучение (CLIP) и контролируемое обучение (DeiT-III).

Эти артефакты обладают четырьмя ключевыми характеристиками:

- Высокая норма: L2-норма токенов артефактов может быть в 2–10 раз больше, чем средняя норма токенов, в зависимости от метода обучения.

- Разреженность: Они составляют небольшую долю от общего числа токенов (приблизительно 2%) и образуют отчетливую моду в распределении (например, рис. 3 и 4 в работе Darcet et al 20241).

- Локализация пятен: они преимущественно появляются в областях фона с низкой информативностью или в углах изображения.

- Локализация по слоям: Они появляются преимущественно в средних и поздних слоях ВИТ.

Влияние артефактов, соответствующих высоким нормам

Влияние на точность варьируется в зависимости от задачи. Мы измеряем это влияние, наблюдая, насколько улучшается производительность после применения исправлений, обсуждаемых в последующих разделах. Ниже приведено краткое изложение результатов работы Цзяна и др. (2025)2:

| Влияние | Задача | Результат смягчения последствий |

|---|---|---|

| 😐 | Классификация ImageNet | Значительного влияния не обнаружено. |

| 😃 | Неконтролируемое обнаружение объектов (LOST) | Значительное улучшение (20%) по показателю DINOv2 ViT-L/14 |

| 😊 | Сегментация без предварительного обучения | +5 млн IOU для OpenCLIP ViT-B/14, но не для DINOv2. |

| 😊 | Оценка глубины | Незначительное улучшение при использовании регистров времени тестирования (более низкая среднеквадратичная ошибка). |

Причина: две гипотезы

Почему эти модели генерируют артефакты, соответствующие высоким нормам? Существуют две основные, непротиворечивые гипотезы:

- Глобальная обработка: Крупные модели учатся выявлять избыточные токены и перепрофилировать их в качестве «слотов хранения» для обработки и извлечения глобальной информации.

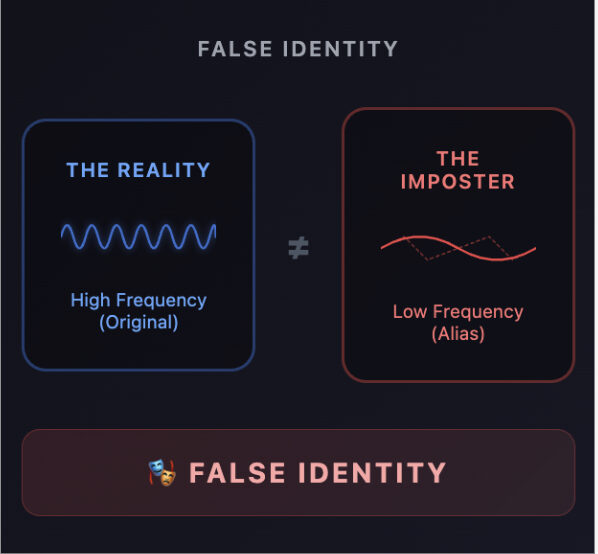

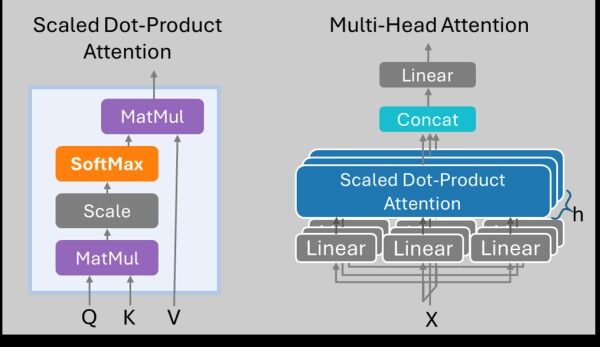

- Механистическая гипотеза: артефакты являются побочным продуктом функции Softmax, которая заставляет весовые коэффициенты внимания суммироваться до 1.

В механизме внимания SoftMax сумма весов для данного запроса должна равняться 1:

$$sum_{j} text{Внимание}(Q, K_j) = 1$$

Даже когда токен запроса ( i ) не имеет значимой связи ни с одним ключевым токеном ( j ), операция SoftMax заставляет его распределять свою «массу внимания». Эта масса часто направляется в определенные фоновые токены с низким содержанием информации, которые затем становятся ловушками для высокоинформативных токенов.

Они рассчитываются отдельно для каждого элемента внимания. Чтобы действительно понять проблему «приемника внимания», мы пошагово разберем код механизма внимания. Диаграммы самовнимания также воспроизведены на рисунке 2 для справки.

Пример кода можно посмотреть в репозитории DeiT на GitHub исследовательского подразделения Facebook:

class Attention(nn.Module): # … def forward(self, x): # B: размер пакета # N: длина последовательности (# токенов) # C: размер встраивания * num_heads B, N, C = x.shape # self.qkv — это линейный слой со смещением, которое утраивает размер # тензора — вычисление Q=XW_Q, K=XW_K, V=XW_V в одном уравнении qkv = self.qkv(x).reshape( B, N, 3, # включает Q, K и V — это измерение переставляется в # индекс 0 self.num_heads, C // self.num_heads).permute(2, 0, 3, 1, 4) q, k, v = qkv[0], qkv[1], qkv[2] q = q * self.scale # для численной стабильности attn = (q @ k.transpose(-2, -1)) # attn: [B x N x N] attn = attn.softmax(dim=-1) # Создание артефакта attn = self.attn_drop(attn) # Дополнительная аугментация обучения с использованием Dropout # Следующая строка выполняет умножение матриц И конкатенацию между заголовками x = (attn @ v).transpose(1, 2).reshape(B, N, C) x = self.proj(x) # еще один линейный слой x = self.proj_drop(x) # Дополнительная аугментация обучения с использованием Dropout return x

В ViT, где отсутствуют явные «глобальные» токены (кроме токена [CLS]), модель перепрофилирует фоновые фрагменты в качестве «поглотителей внимания» или «мусорных корзин». Эти токены агрегируют глобальную информацию, их нормальная величина увеличивается, а их первоначальное локальное семантическое значение теряется.

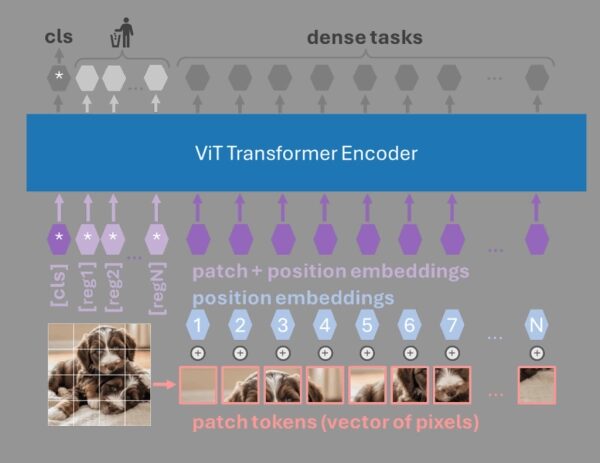

2. Решение с использованием регистров: Для преобразования изображений необходимы регистры (2024)

Команда разработчиков DINOv2 обнаружила эти артефакты, связанные с высокой нормой, и предложила добавить «регистровые» токены (Darcet et al. 20241). Эти токены представляют собой обучаемые токены, подобные токену [cls], но без позиционных вложений, однако соответствующие выходные токены никогда не используются. По сути, это просто дополнительные токены, которые не используются напрямую для обучения. Эти регистровые токены обучаются так же, как и токен [CLS], и не имеют позиционных вложений. Главный недостаток этого метода заключается в необходимости переобучения модели. Это ограничение подтолкнуло к поиску постфактумных решений, которые могли бы исправить существующие модели.

3. Решение для подавления шума: Denoising Vision Transformers (2024)

Ян и др. (2024)4 предложили шумоподавляющие видеотрансформаторы (DVT) для постобработки выходных токенов. Хотя DVT синергичен с регистрами, он создает значительное узкое место, добавляя примерно 100 секунд задержки на каждое изображение размером 518×518 пикселей, что делает его непрактичным для приложений реального времени.

Вклад:

- Тромбоз глубоких вен улучшает выполнение различных задач, и авторы показали, что тромбоз глубоких вен оказывает синергетический эффект при добавлении регистров.

- Данная статья расширяет наше понимание того, что вклад позиционных вложений является одной из основных причин возникновения артефактов, связанных с высокими нормами.

Однако:

- Это приводит к значительной задержке на каждое изображение (около 100 секунд для изображений размером 518×518 пикселей).

4. Решение для дистилляции: регистры самоперегонки (2025)

Подход, предложенный Ченом и др. (20255), использует парадигму «учитель-ученик» для обучения небольшого подмножества весов и регистровых токенов. Артефакты, связанные с высокой нормой, удаляются из сигнала учителя путем применения аугментации данных с помощью случайных смещений и отражений к изображениям, что позволяет усреднить эти артефакты. Модель учителя остается неизменной, как и исходный ViT. Модель ученика также инициализируется из того же ViT, однако добавляются дополнительные обучаемые регистровые токены, и небольшое подмножество весов дорабатывается.

Вклад:

- Вычислительные ресурсы на порядки меньше, чем при обучении с нуля с использованием регистров.

- Отсутствие дополнительной задержки во время тестирования.

5. Механистическое решение: Регистры времени тестирования (2025)

Цзян и др. (2025)2 представили метод «хирургического вмешательства» в обученные модели для добавления регистров без переобучения. Они обнаружили, что артефакты генерируются разреженным набором специфических «регистровых нейронов» внутри слоев MLP (примерно 0,02% от всех нейронов). Перенаправляя значения из этих внутренних нейронов MLP на новые регистровые токены, они достигли производительности полностью обученных регистровых моделей с нулевыми затратами на переобучение.

Они обнаруживают следующие свойства нейронов (или «регистровых нейронов»), вызывающих артефакты:

- Разреженность: Примерно 0,02% нейронов отвечают за подавляющую часть энергии артефактов.

- Причинно-следственная связь: положение выбросов можно изменить, модифицировав паттерн активации нейронов регистра.

Они показывают, что эти нейроны-регистраторы агрегируют глобальную информацию, используя линейные зонды: то есть, они проверяют, могут ли они использовать нейроны-регистраторы для классификации на ImageNet и CIFAR-10/100. Последний выходной сигнал регистраторов игнорируется, но в сети есть токены регистров, где сеть может использовать эту глобальную информацию. Авторы проводят эксперименты, чтобы показать, что обнуление нейронов-регистраторов существенно снижает производительность сети с 70,2% до 55,6%, что предполагает, что сети используют артефакты для хранения информации, а не являются просто артефактом SoftMax.

Взаимосвязь между артефактами ViT High-Norm и эффектами привлечения внимания LLM.

Феномен, аналогичный артефактам высокой нормы ViT — «ловушкам внимания» — был обнаружен в LLM в статье StreamingLLM (Xiao et al., ICLR 20246). Расширяя LLM для использования на потоковых последовательностях бесконечной длины, они заметили, что точность значительно снижается, когда начальный токен перестает помещаться в скользящее окно. Эти начальные токены, как они обнаружили, имеют тенденцию накапливать более половины оценки внимания. Снижение точности восстанавливалось, если они сохраняли значения ( K ) и ( V ) от начальных 1-4 токенов, перемещая окно по оставшимся токенам. Они предполагают, что начальные токены используются в качестве «ловушек внимания» из-за последовательной природы авторегрессивного языкового моделирования: они видны всем токенам, в то время как более поздние токены видны только последующим токенам. Это контрастирует с ViT, где каждый токен фрагмента виден каждому другому токену фрагмента. В случае с программами LLM проблема отвлечения внимания, как правило, не рассматривалась, в отличие от программ ViT.

Считалось, что «ловушки внимания» в LLM служат якорями, не агрегируя глобальную информацию — в отличие от ViT; однако даже более недавнее исследование Кейпо-де-Льяно и его коллег (Queipo-de-Llano et al 20257), «Ловушки внимания и долины сжатия», показывает, что эти «ловушки внимания» действительно содержат глобальную информацию. Это говорит о том, что общее решение, обсуждаемое в следующем разделе, может также применяться к ViT, хотя на момент написания этой статьи оно на них не проверялось.

7. Удаление артефактов с помощью сигмоидального управления: управляемое внимание (2025)

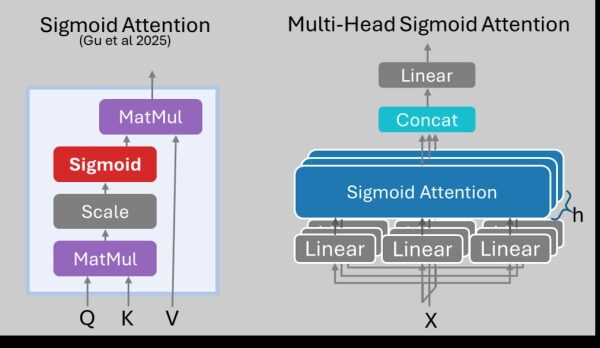

Одним из способов решения проблем, связанных с SoftMax, может быть его замена на сигмоидную функцию. Гу и др. 8 в 2025 году показали, что замена SoftMax на (ненормализованную) сигмоидную функцию действительно может устранить эффект «поглотителя внимания» на первом токене, как показано на рисунке 4. Хотя предварительные результаты показывают некоторое потенциальное улучшение функции потерь при валидации, остается неясным, какое влияние это окажет на производительность LLM в дальнейшем, и отсутствуют надежные эксперименты, которые будут представлены в нашей следующей статье.

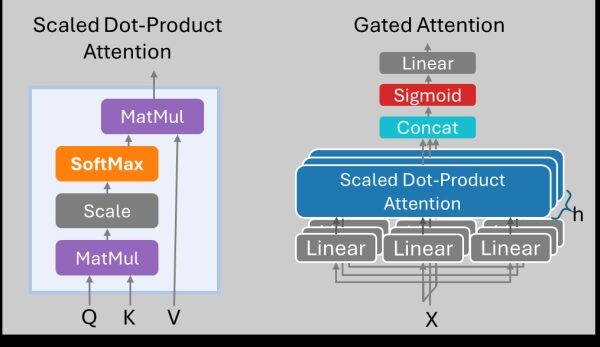

В своей статье, представленной на конференции NeurIPS 2025, Цю и др. сделали нечто иное: они оставили механизм внимания SoftMax без изменений, но затем добавили механизм управления после объединения токенов из всех голов, как показано на рисунке 5. Они обнаружили, что добавление механизма управления устраняет артефакты, связанные с высокой нормой, хотя механизм внимания SoftMax все еще создавал бы такие артефакты до добавления механизма управления внутри стандартного механизма внимания с масштабированным скалярным произведением (SDPA). Преимущества механизма внимания с управлением выходят за рамки устранения артефакта, связанного с механизмом внимания, и предлагают:

- Улучшена стабильность тренировок

- Устранение резких скачков потерь в процессе тренировок

- Поддержка более высоких скоростей обучения и размеров пакетов.

В своей новой модели Qwen3-Next они используют механизм Gated Attention, хотя и заменяют часть механизма самовнимания на Gated DeltaNet. Это может быть признаком того, что мы отходим от отдельных элегантных решений, таких как повторяющиеся модули самовнимания, и всё больше склоняемся к набору ухищрений или эвристик, обеспечивающих наилучшую производительность. Во многом это похоже на работу мозга с его широким разнообразием типов нейронов, нейромедиаторов и нейрорецепторов. Более масштабные изменения архитектуры могут нарушить равновесие прогресса и потребовать повторной настройки набора эвристик.

8. Заключение

С тех пор, как в далеком 2024 году были обнаружены артефакты высокой нормы в ViT и «ловушки внимания» в LLM, исследовательское сообщество нашло множество решений и добилось значительного прогресса в понимании этих артефактов. Артефакты оказались более похожими, чем предполагалось изначально. В обоих случаях SoftMax приводит к существенному увеличению внимания к некоторым токенам, которые используются (неявно или явно) в качестве регистров, хранящих глобальную информацию. Удаление этих регистров может ухудшить производительность после их изучения. Регистры времени тестирования перемещают артефакты высокой нормы (или неявные регистры) в явные регистры, позволяя очистить токены исправлений от артефактов. Вы также можете предотвратить формирование регистров, заменив SoftMax сигмоидной функцией или используя сигмоидную функцию в качестве управляющей функции после SoftMax (хотя последний вариант допускает артефакты высокой нормы внутри SDPA, но они удаляются до того, как образуются «токены»).

Во многих случаях эти артефакты не вызывают никаких проблем, например, в глобальных задачах, таких как классификация для ViT и большинство задач LLM. Они негативно влияют на задачи с плотными массивами ViT, особенно когда один или несколько токенов могут оказывать чрезмерное влияние, например, при обнаружении объектов. Исправления, по крайней мере, не ухудшают производительность, хотя исправления для LLM, такие как сигмоидное внимание и вентильное внимание, не получили такого широкого распространения, и — в частности, сигмоидное внимание — может быть сложнее в обучении. Использование артефакта — копирование значений ключ-значение исходных токенов — представляется на данный момент лучшим зрелым решением для потоковых LLM6.

Сравнение стратегий смягчения последствий

Наилучшая стратегия смягчения последствий зависит от того, есть ли у вас уже обученная модель или вы планируете обучать ее с нуля.

| Метод | Стоимость обучения | Механизм | Задержка | Применяется к |

|---|---|---|---|---|

| Обученные регистры1 | Высокий (Полный) | Добавить изученные токены | Никто | Витамины |

| Шумоподавление ViTs4 | Середина | Разложение сигнала | Очень высокий | Витамины |

| Самодельный дистиллят5 | Низкий (тонкая настройка) | Дистилляция | Никто | Витамины |

| Регистры времени тестирования2 | Ноль | Сдвиг нейронов | Никто | Витамины |

| Потоковое обучение LLM6 | Ноль | Сохранение кэша KV | Никто | Магистратура по праву |

| Сигмоидная или Элу+1 Внимание8 | Высокий (Полный) | Заменить SoftMax | Никто | Магистратура по праву |

| Внимание, ограниченное доступом9 | Высокий (Полный) | Добавить сигмоидную фильтрацию | Минимальный | Магистратура по праву |

Библиография

- Дарсе, Т. и др. «Трансформаторам машинного зрения нужны регистры». (2024).

- Цзян Н. и др. «Трансформаторам машинного зрения не нужны обученные регистры». (2025).

- Васвани, А. и др. «Внимания достаточно». (2017).

- Ян и др. «Трансформаторы для подавления шума в видео». (2024).

- Чен, Ю. и др. «Трансформаторы зрения с самодистиллированными регистрами». NeurIPS (2025).

- Сяо и др. «Эффективные потоковые языковые модели с механизмами внимания». ICLR (2024).

- Кейпо-де-Льяно и др. «Поглощение внимания и долины сжатия». (2025).

- Гу и др. «Когда в языковых моделях возникает эффект «поглотителя внимания»: эмпирический взгляд». ICLR (2025).

- Цю, З. и др. «Управляемое внимание для больших языковых моделей». NeurIPS (2025).

Источник: towardsdatascience.com