NVIDIA делает ИИ дешевле — ставка на LPU и энергоэффективность

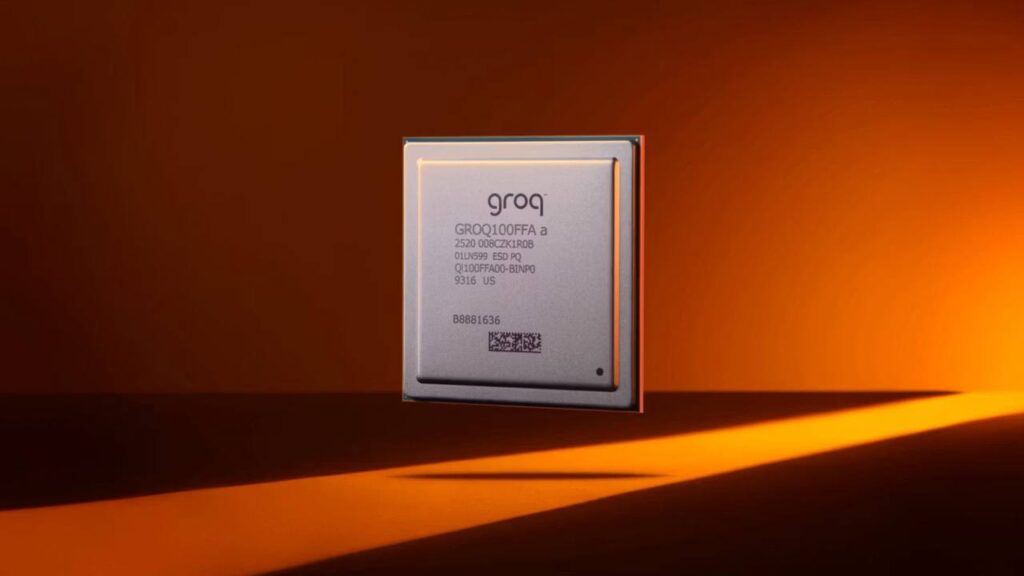

NVIDIA делает ход на опережение: компания заключила стратегическое соглашение со стартапом Groq на лицензирование технологий для энергоэффективного инференса ИИ. Следом NVIDIA переманила ключевое руководство партнёра — по данным CNBC, весь манёвр обошёлся примерно в $20 млрд.

Важно не путать: это не чат-бот Илона Маска, а Groq, который с 2016 года разрабатывает собственные LPU (Language Processing Unit) — специализированные чипы, оптимизированные именно под нейросети.

Чем LPU интересны рынку:

— Одноядерная архитектура и детерминированное выполнение

— Без водяного охлаждения, ниже энергопотребление

— Лёгкое масштабирование в серверные стойки дата-центров

— Всего сотни мегабайт встроенной SRAM, без необходимости закупать большие объёмы HBM-памяти

Последний пункт особенно критичен: на фоне дефицита оперативной памяти и HBM-модулей такие чипы становятся экономически привлекательнее классических GPU-решений.

Зачем это NVIDIA:

— Компания активно развивает человекоподобных роботов, которым нужны локальные ИИ-вычисления с жёсткими ограничениями по энергии

— Для инференса «на месте» GPU избыточны и дороги

— LPU закрывают нишу быстрого, дешёвого и предсказуемого инференса

В перспективе это может выйти далеко за пределы дата-центров. Появление LPU в потребительских устройствах откроет путь к локальному запуску нейросетей даже на бюджетных ноутбуках, без дискретных видеокарт и облачных костылей.

Вывод: NVIDIA готовится к следующей фазе ИИ-рынка, где решает не максимальная мощность, а стоимость, доступность и энергоэффективность. Инференс снова выходит на первый план — и LPU выглядят как ключевой элемент этой стратегии.